家里有小孩的朋友应该都有这样的体验:孩子总会问一些奇怪的问题。

例如,飞机为什么会飞上天?地球为什么是圆的?太阳为什么会发光.......

用文字解释吧,孩子听着很枯燥,我们讲起来也费劲。有时候想找一些科普视频,但网上的要么太专业,要么质量参差不齐。最关键的是,孩子的问题千奇百怪,不一定能找到合适的视频。

所以我就想,能否让AI帮我生成一个教育视频?说清楚原理,画面还得好看,最好还能自动配音。

我最近做了一个 Agent Skill 叫 educational-video-creator,就是干这个事的。从输入一个主题,到生成一个完整的教育视频,全程自动化。视觉风格参考了 Kurzgesagt 和回形针,那种扁平化、色彩鲜艳的动画风格,小朋友很喜欢。

这个 Skill 不是简单地把文字转成视频。它会自动写脚本、设计分镜、画动画、生成配音,还会自动检查质量。说白了,就是把一个专业视频团队的工作流程,用AI跑了一遍。

项目已开源:github.com/skindhu/ski…

一、为什么要做这个?

传统的科普视频制作,门槛其实挺高的。你得会写脚本、懂设计、会动画、能配音,还得有专业的视频编辑软件。对于普通家长来说,这基本不可能。

就算找现成的视频,也有问题。孩子问的问题太个性化了,网上不一定有。而且很多科普视频要么太浅显,要么太专业,很难找到刚好适合的。

其实核心痛点就是:个性化的教育内容,制作成本太高。

但如果有 AI 帮你自动生成呢?你只需要说一个主题,比如"为什么飞机能飞",剩下的全交给 AI。它自动写脚本、画动画、配音,十几分钟后给你一个成品视频。

这就是 educational-video-creator 要解决的问题。

二、技术选型:为什么选 Remotion?

做视频有很多方案,我最终选了 Remotion。

Remotion 是一个开源的视频创作框架,核心理念挺简单:用 React 写视频。你用 HTML、CSS、TypeScript 来描述画面和动画,Remotion 负责把它渲染成真正的视频文件。

选它的原因也简单:代码生成的视频,天然适合 AI 来写。传统视频编辑软件靠手动拖时间线、调参数,AI 没法操作。但 Remotion 不一样,所有画面、动画、时间控制都是代码,而AI写代码是强项。

Remotion 官方最近还把最佳实践封装成了 Claude Code 的 Skill(https://github.com/remotion-dev/skills)。装上这个 Skill 后,Claude Code 就掌握了 Remotion 的动画技巧、组件模式、音视频处理等几十条最佳实践,写出来的视频代码质量直接拉满。

说白了,Remotion 把视频制作变成了软件工程问题,而 Remotion 官方又把软件工程的最佳实践喂给了AI。如此一来,AI 生成视频这件事就变得靠谱了。

三、从主题到成品:完整的创作流程

educational-video-creator 把视频制作拆成了几个阶段。下面一个一个说。

需求收集

第一步是明确需求。AI 会跟你确认五类信息:主题和范围(讲什么、不讲什么、有没有常见误区要纠正)、目标观众(年龄段、知识水平、语言)、视频规格(时长、分辨率、帧率)、内容要求(学习目标、必须包含的元素、视觉偏好)、旁白和音频(是配音还是纯字幕、语气风格、要不要背景音乐)。

这些问题不是随便问的。它们直接决定了后面每个阶段的产出。

比如,给5岁小孩讲飞机,你得用"翅膀拍打空气"这种简单类比,语气要活泼。给中学生讲,就得提伯努利原理和升力公式,语气可以正式一些。确认完所有需求后,AI 会做一次校验,确保主题、观众、学习目标都明确了,才进入下一阶段。

脚本创作

有了需求,AI 开始写脚本。

这个阶段只关注"讲什么"。脚本包括四个部分:核心信息(一句话总结和学习目标)、叙事策略(用什么角度切入、核心比喻是什么、情感弧线怎么走、知识点按什么顺序递进)、完整旁白文字稿、节奏标注(哪里加速、哪里放慢、哪里停顿让观众消化)。

脚本里也会写简短的"视觉意图",比如"从侧面展示飞机,四个箭头表示四种力"。但不会写任何技术参数,坐标、帧号、动画配置这些都是分镜阶段的事。

刚开始我是让AI直接设计视频分镜,经过尝试后还是决定先写脚本。因为写故事和设计画面是两个完全不同的思维模式。如果你让 AI 同时想"说什么"和"画什么",它很容易顾此失彼。分开之后,AI 可以专注于把故事讲好。而且纯文本脚本很容易修改,如果我们觉得某段话不对,直接改文字就行。等脚本定稿了,再进入下一阶段。

分镜设计

脚本定稿后,AI 开始设计分镜。这个阶段要把文字转换成视觉。

具体来说,就是把脚本拆成 5-15 个场景,给每个场景分配旁白,设计视觉图层(背景、中景、前景、UI),定义动画参数,设计旁白和画面的同步点,列出需要的 SVG 组件和配色。

这个阶段的产物是一个详细的分镜文档。有了这个文档,后面的编码就是纯执行了。

视觉设计

视觉风格参考了 Kurzgesagt 和回形针:扁平化设计、高饱和度配色、几何图形、无衬线字体。

这种风格简单、清晰,很视频教育类主题。而且扁平化设计用代码很好实现,不需要复杂的 3D 渲染,SVG 就够了。

动画编码

有了分镜和视觉规范,开始编码。

Remotion 的动画原理其实很简单:通过 useCurrentFrame() 拿到当前帧号,然后用 interpolate() 把帧号映射成各种视觉属性,比如位置、透明度、缩放。所有动画都是这个逻辑:帧号进去,属性值出来。想要更自然的效果,还可以用 spring() 函数模拟弹簧动画。

因为 Remotion 基于 React,所以可以把常用的视觉元素封装成组件,比如字幕、图标库、配色方案、字体预设。这些组件做一次就能反复用,AI 生成代码时也不容易出错。

音频生成

动画做完,就到配音阶段。

配音用的是 Edge TTS,微软提供的免费 TTS 服务,无需 API Key。中文音色推荐 zh-CN-XiaoxiaoNeural(女声,清晰自然)或 zh-CN-YunxiNeural(男声,温暖亲切)。还可以调语速,比如减慢 10% 更适合教学场景。对比 OpenAI TTS 或 Azure TTS,Edge TTS 音质不差,而且完全免费,个人项目用起来没负担。

这里有个关键问题:旁白时长和动画时长怎么匹配?

一开始设计分镜时,只能估计每段话要说多久。实际生成音频后,肯定有偏差。所以我做了一个时间线重建功能:先测量所有 TTS 音频的实际时长,然后按算法重新计算每个场景的帧范围,每段音频之间留 0.2 秒间隙,每个场景首尾留 0.5 秒填充,节奏感很好。如果新旧时长偏差超过 20%,还会自动警告。

这样就能保证音频和动画同步(有些场景还是没有完全同步,不过问题不大)。

质量检查

最后是自动质量检查:代码扫描(检查字号、颜色、安全区域是否合规)、关键帧截图(渲染几个关键帧做视觉检查)、自动修复、启动预览。

这个流程可以循环。如果检查不通过,AI 会根据报告修复代码,然后再检查,直到通过。

四、实际效果

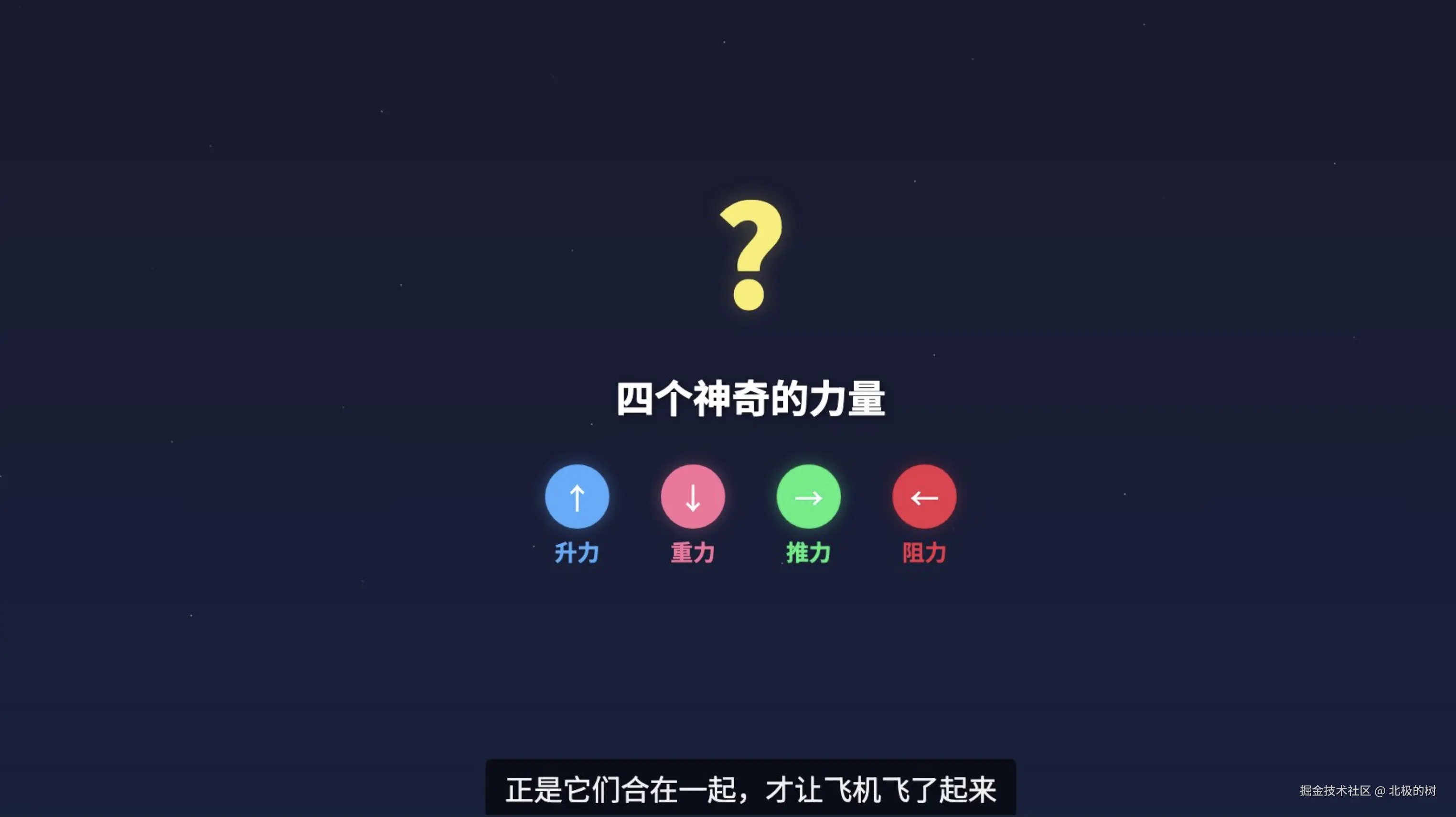

我用这个Skill生成了几个视频,主题包括"为什么飞机能飞"、"为什么太阳会发光"、"为什么地球是圆的"。

从输入主题到生成成品,大概需要 5-10 分钟,包括写脚本、设计分镜、编码、生成 TTS、渲染视频。

视觉风格确实很接近 Kurzgesagt,扁平化、色彩鲜艳、动画流畅。配音也挺自然,听不太出是机器合成的。

不足也有。动画目前还比较基础,主要是淡入淡出、移动、缩放,复杂的流体或粒子效果不好做。视觉风格也比较单一,目前只做了 Kurzgesagt 风格。

但对于"快速生成一个能看的教育视频"这个目标,够用了。

视频部分预览如下:

写在最后

做这个 Skill 的过程中,我一直在想一个问题:以前做一个科普视频,需要编剧、动画师、配音师、剪辑师,一个团队协作好几天。现在一个 AI Agent,几分钟就能跑完整个流程。

这个东西不只能回答孩子的问题。在线教育、企业培训、产品演示,任何需要把知识可视化的场景,都能用。

如果你也有兴趣,这个 Skill 作为 Claude Code 的 Agent Skill 使用,技术栈是 Remotion + React + TypeScript + Edge TTS。